什么软件能把花呗刷现,怎样把花呗的钱转出来

|

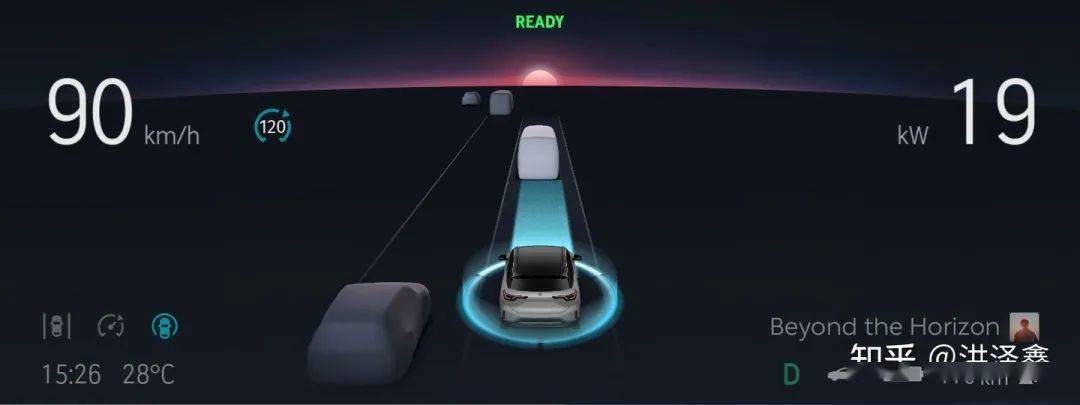

8月12日,美一好公司创始人林文钦驾驶蔚来ES8汽车启用自动驾驶功能后,在高速发生交通事故不幸逝世。 作为一名自动驾驶行业的从业者,看今天的消息后心里挺难过的。 可能很多年后,历史会这么记录这一时期: “自动驾驶技术刚出现的时候,还很不成熟,但却有不少人因为被误导,以为已经足够成熟了,并因此丢掉了性命。” 早在2013年,谷歌就在研发一批具备一定自动驾驶能力的车,而且征集了一部分员工进行内部测试,给他们每人分发了一辆车,告诉他们在车上不能分神,注意力必须放在驾驶上,并且很严肃地警告他们,如果车内的摄像头发现他们没有严格遵守这个规定,会马上收回车辆。 但在测试的过程中,谷歌发现有好几个员工都没有严格遵守规定,并且有一位员工直接在车上睡着了——他睡着的时候,车辆正以55英里每小时的速度在路上飞奔。 在这件事发生了以后,谷歌就彻底关闭了这个项目,并开始专心研发L4级别的无人驾驶技术。 [1] 可以说,在2013年谷歌就意识到类似NOP的功能的普及需要挑战人性。 蔚来的NOP是什么? NOP的全称是Navigate on Pilot,中文是领航辅助,一般对外宣传会说是“实现A点到B点自动领航驾驶,包括自动上下匝道、超车、并线、巡航行驶等功能”。

属于介于L2至L3级别之间的自动驾驶功能。

说实话,最大的作用只在于你对路不熟的时候不容易开错路,因为方向盘会提醒你一下。 绝对不要让车辆自己驾驶,重要的事情说三遍: 不要走神。 不要走神。 不要走神。 为什么自动驾驶会出问题? 无人驾驶技术目前还存在没解决的问题,或许技术上已经解决了90%的问题,但剩下的10%却可能要花费同样多甚至更多的精力,这10%包括很多长尾问题,经常被称为Corner Case。在没有全部解决这些长尾问题的情况下,就依然需要有人员介入。 目前已经量产的车辆不涉及特别复杂的车辆控制问题,所以目前这些问题大都集中在感知领域,也就是错误识别物体或者根本没有能识别出有物体。 单纯靠摄像头没法保证能识别所有东西。人靠眼睛在开车,摄像头离人类的眼睛还有很长距离的,人的眼睛是非常强大的传感器,低功耗,大部分光线情况下都能起作用,还自带防尘装置——眼皮。 大家会说人工智能不是很神了嘛,为什么那么大一台车在前面还识别不出来?

根源是在于人工智能的“可解释性”挑战,现在的机器学习就像一个黑盒子,你给这个黑盒子一个照片,黑盒子会告诉你这个照片里有什么没有什么,但黑盒子却不会告诉你为什么有或者为什么没有。 不可解释的黑盒子系统是不能用在关乎安全的应用领域的,自动驾驶尤其是这样。 有不少人工智能公司会认为大量的数据就能让人工智能更精准、更智能,但终究还是一个黑盒子,根本不是单纯靠大量数据能解决的。 这也是为什么越来越多车厂在新车上装激光雷达,激光雷达和摄像头之间可以交叉验证、互为冗余,摄像头看不到的东西激光雷达能感知到,激光雷达感知不到的,摄像头可以。 L3级别的自动驾驶出了问题能找谁? 事故责任只能是自己承担。 L3级别的自动驾驶要求司机随时把注意力都放在驾驶上,所以出事故了,按照现有交通法规,只能认定是司机在违规驾驶。 2016年1月20日,是中国首例“自动驾驶”致死车祸发生的时间,也是全球首例。当时在京港澳高速河北邯郸段上,一辆特斯拉轿车直接撞上一辆正在作业的道路清扫车,特斯拉司机高雅宁当场身亡。 [2]

后来经交警认定,在这起追尾事故中驾驶特斯拉的司机高雅宁负主要责任。 家属状告特斯拉只能以“宣传误导”的名义,索赔一万元,但这起案件过去五年了,至今还悬而未决。 没有法律法规能管一管吗? |

支付宝扫一扫

支付宝扫一扫 微信扫一扫

微信扫一扫

评论列表